[Github] 구글 검색 엔진에 내 블로그 등록하기

07 Jan 2021 | git blog github jekyll seo💻 구글 검색 엔진에 등록해보자

호기롭게 블로그를 만들었다. 첫 글도 작성했고…

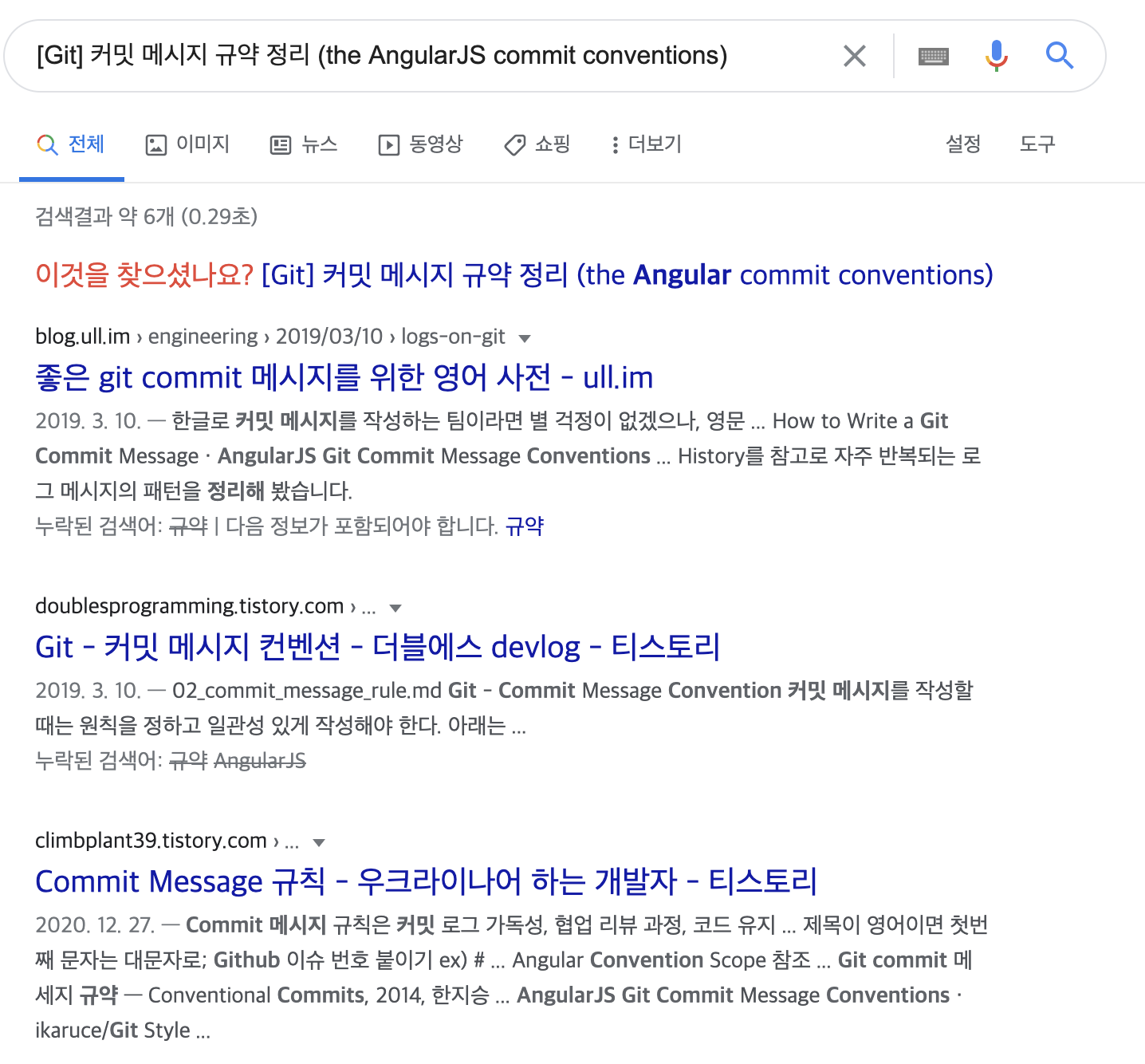

이제 내가 쓴 글을 확인하려고 구글 검색을 해보았다.

안나온다…

😨 왜 안나올까?

검색 엔진이 내 블로그의 존재를 모르기 때문이다.

그러므로 검색엔진에게 직접 내 블로그에 대해 알려줘야한다.

🧐 어떻게 알려주지…?

- Google Search Console 에

속성을 추가하고 인증한다. sitemap.xml을 작성 및 등록한다.robots.txt를 작성한다.

1. Google Search Console 에 속성 추가 및 인증

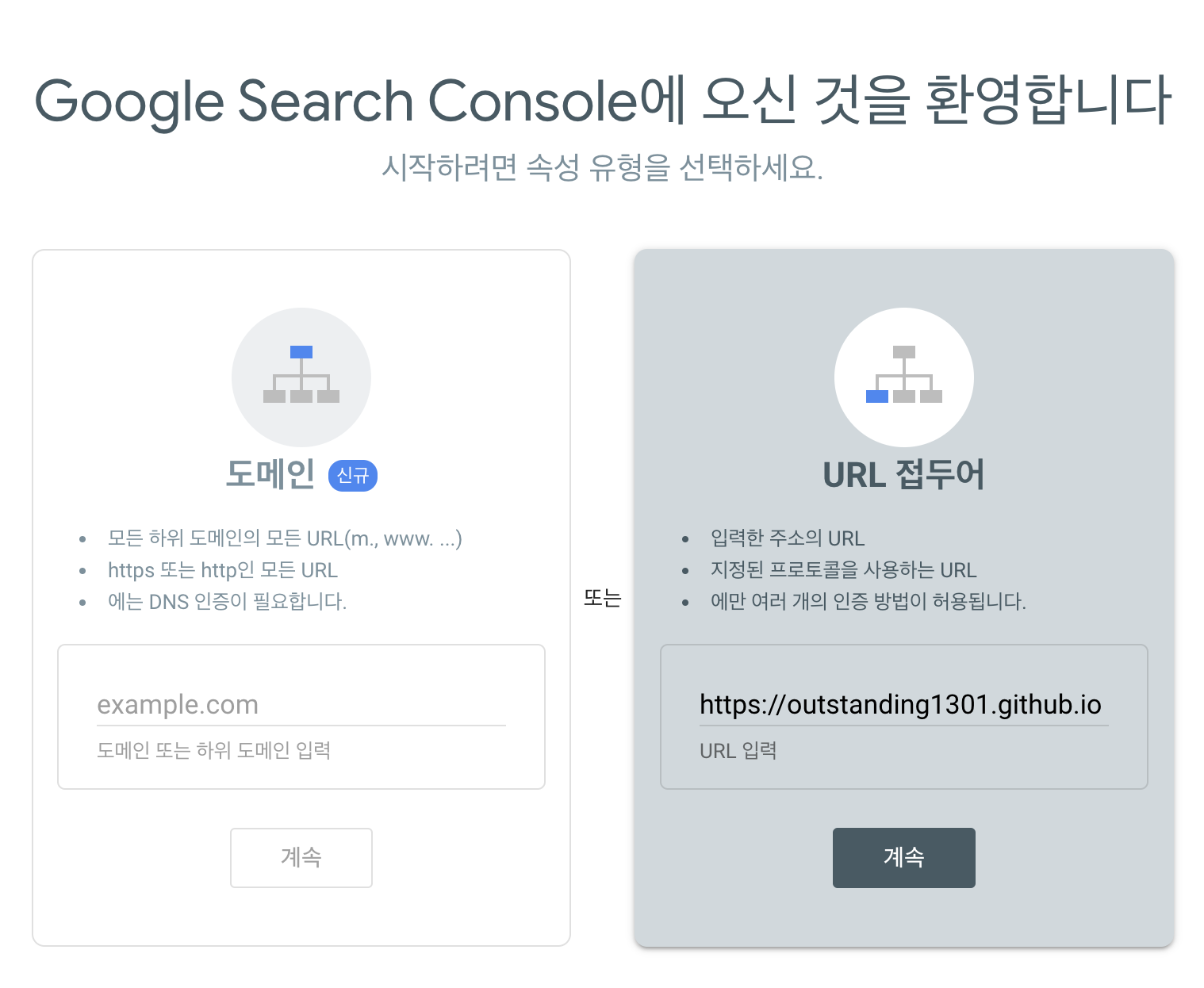

Google Search Console 에 접속하여 블로그 URL을 입력하자.

Google Search Console 에 접속하여 블로그 URL을 입력하자.

왼쪽 도메인 입력으로 할 경우에는 DNS 레코드에 TXT를 추가해야하는데,

우린 github.io를 이용하므로 이는 불가능하다.

따라서 오른쪽 URL 접두어에 입력한다.

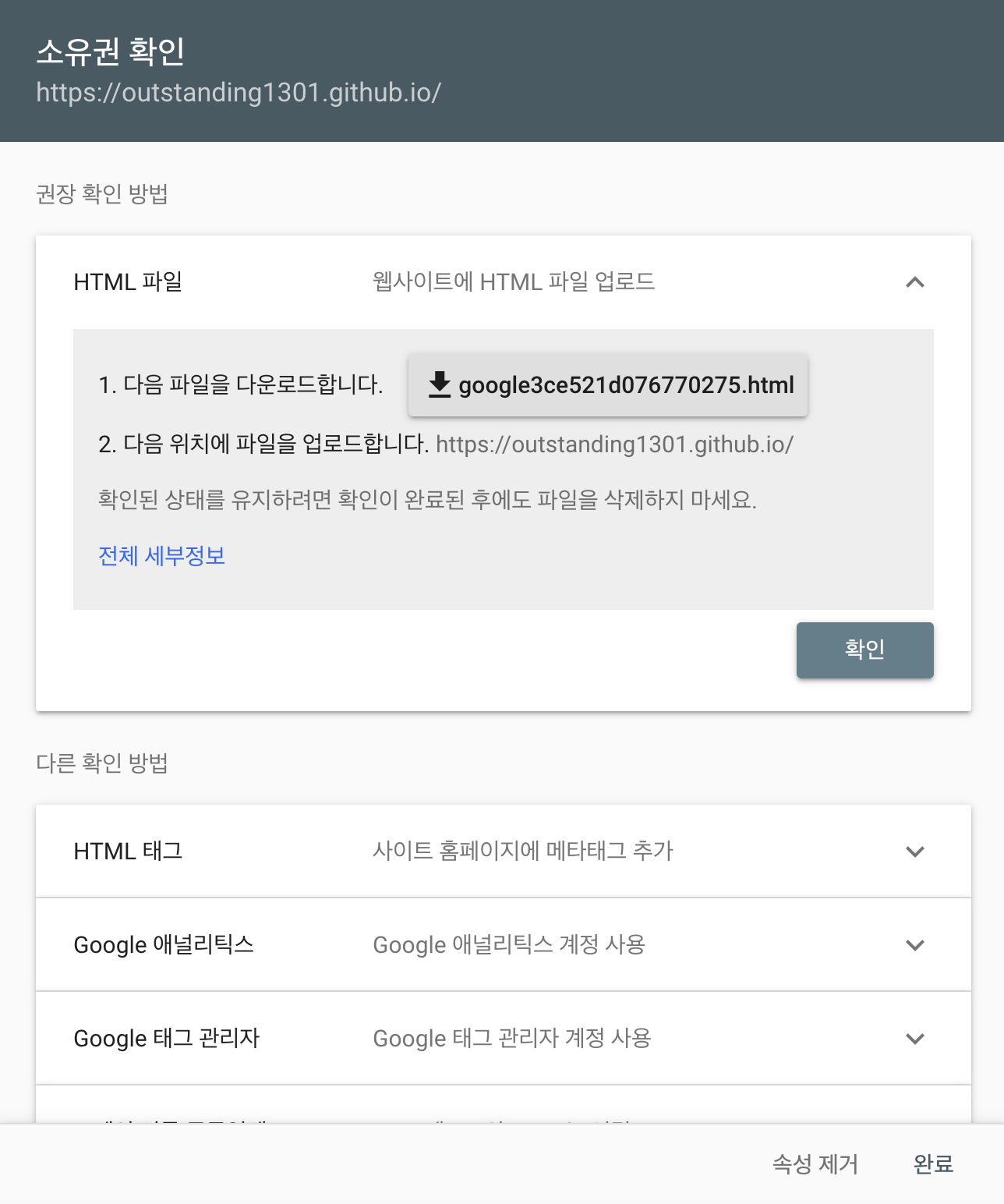

이제 HTML 파일을 다운로드 받아서 Github 저장소에 등록하면 된다.

저장소의 루트 디렉토리에 저장하고 Github 저장소에 등록한다.

git add [HTML 파일]

git commit -m "docs: google search console 인증 파일 추가"

git push origin master

이제 확인 버튼을 누르면 소유권이 인증 된다.

소유권이 인증되었다.

2. sitemap.xml 작성 및 등록

저장소의 루트 디렉토리에 sitemap.xml 파일을 생성한다.

이 파일의 내용을 붙여넣기 한다.

반드시 1~2행의

---도 입력해야한다!

마찬가지로 Github 저장소에 등록해준다.

git add sitemap.xml

git commit -m "docs: sitemap.xml 추가"

git push origin master

https://블로그주소/sitemap.xml 에 접속해 sitemap.xml이 정상적으로 등록되었는지 확인한다.

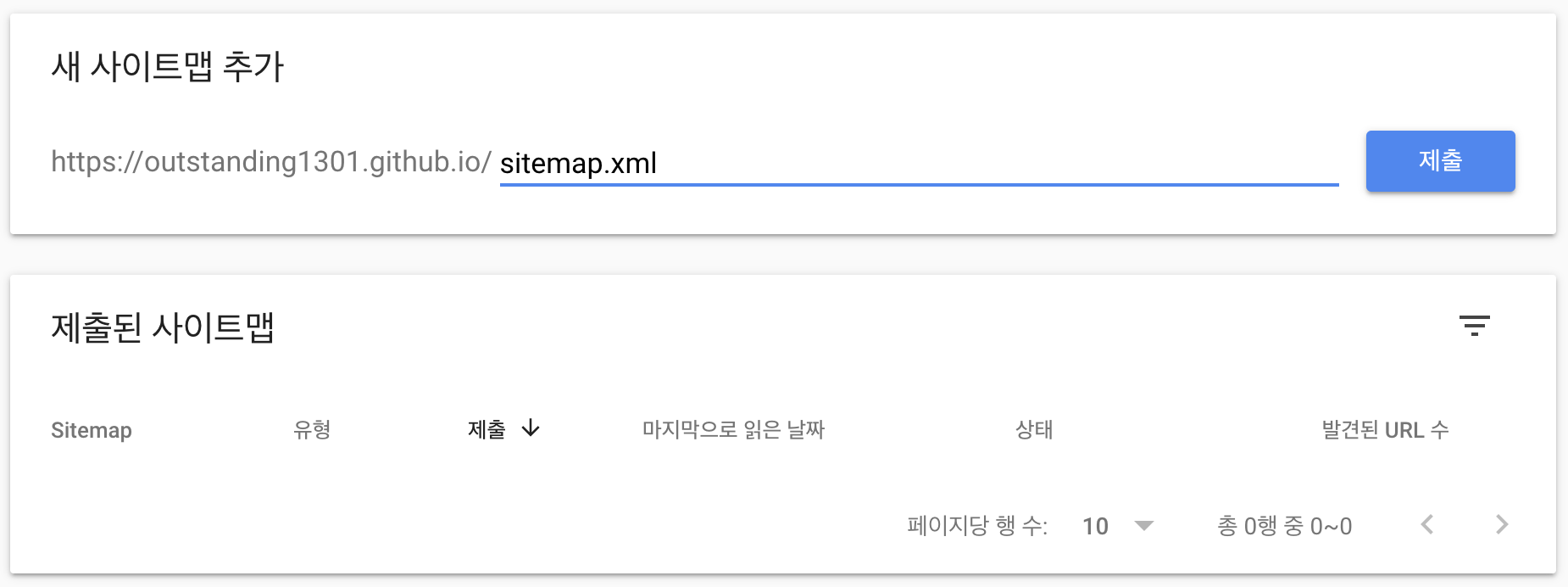

이제 Google Search Console에 사이트맵을 제출하면 된다.

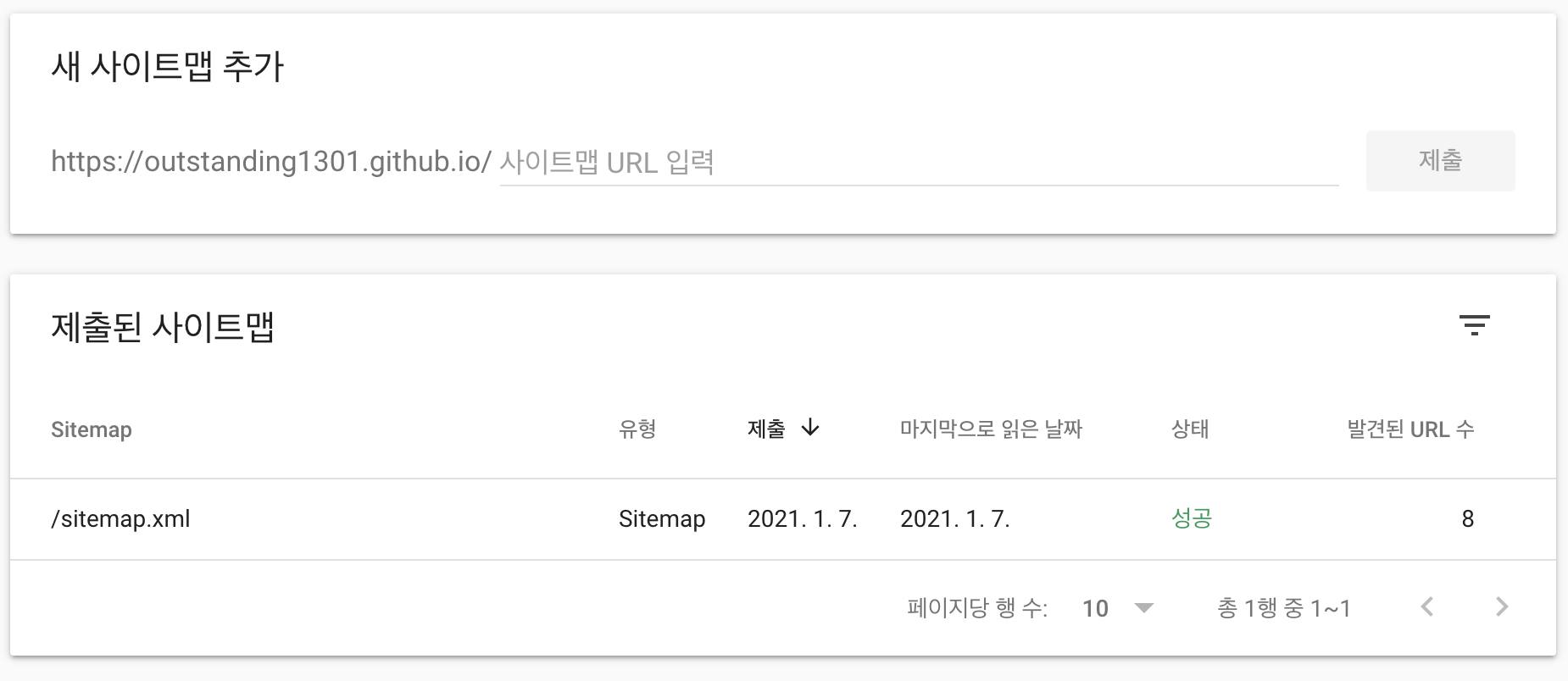

Google Search Console 에서 아까 등록한 속성을 선택하고 Sitemaps 탭으로 이동한다.

사이트맵 URL 입력에 sitemap.xml을 입력하고 제출한다.

성공적으로 등록되었다!

3. robots.txt 작성

robots.txt는 검색 엔진의 크롤러의 웹 문서 접근을 허가하거나 차단하기 위해 기술되는 문서이다.

자세한 내용은 로봇 배제 표준을 참고하자

일단은 모든 검색 엔진의 크롤러가 모든 문서에 접근하는 것을 허락할 것이다.

User-agent: *

Allow: /

Sitemap: http://outstanding1301.github.io/sitemap.xml

sitemap.xml 의 경로도 명시해주었다.

마찬가지로 Github 저장소에 등록하자.

git add robots.txt

git commit -m "docs: robots.txt 추가"

git push origin master

🔎 이제 구글에 내 글을 검색해보자

아직 안나온다…

완전히 등록되는데에 한 일주일 정도가 걸린다고 하니 천천히 기다려보자 :)